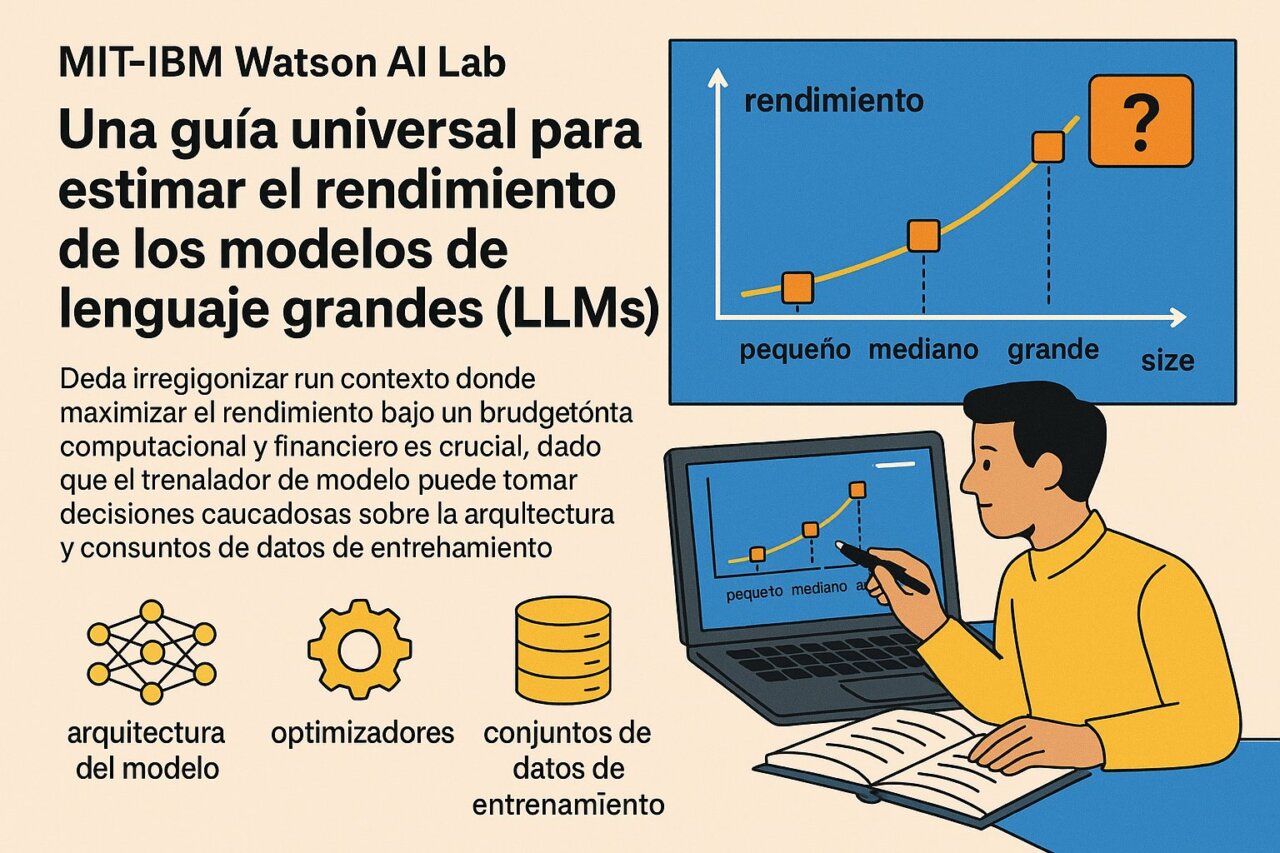

Los investigadores del MIT-IBM Watson AI Lab han desarrollado una guía universal para estimar el rendimiento de los modelos de lenguaje grandes (LLMs) basándose en modelos más pequeños de la misma familia. Esta investigación surge en un contexto donde maximizar el rendimiento bajo un presupuesto computacional y financiero es crucial, dado que el entrenamiento de un modelo puede costar millones de dólares.

En resumen, los desarrolladores deben tomar decisiones cuidadosas sobre la arquitectura del modelo, los optimizadores y los conjuntos de datos de entrenamiento antes de comprometerse con un modelo.

Para anticipar la calidad y precisión de las predicciones de un modelo grande, los profesionales suelen recurrir a las leyes de escalado. Estas leyes permiten usar modelos más pequeños y económicos para aproximar el rendimiento de un modelo objetivo mucho más grande. Sin embargo, la complejidad radica en que existen miles de formas de crear una ley de escalado.

Guía para optimizar el rendimiento de los LLMs

El equipo del MIT-IBM Watson AI Lab ha recopilado y divulgado una colección de cientos de modelos y métricas sobre entrenamiento y rendimiento, lo que permite aproximar más de mil leyes de escalado. A partir de esta información, se desarrolló un meta-análisis y una guía para seleccionar modelos pequeños y estimar leyes de escalado para diferentes familias de LLM, de modo que el presupuesto se aplique de manera óptima en la generación de predicciones de rendimiento confiables.

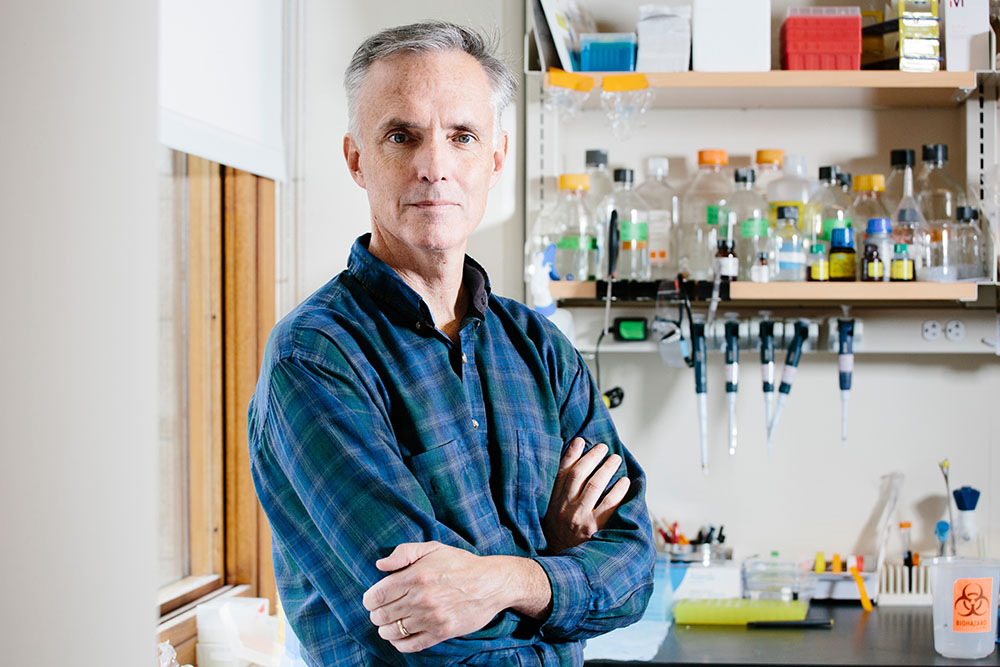

Jacob Andreas, profesor asociado en el Departamento de Ingeniería Eléctrica y Ciencias de la Computación, señala: “La idea de construir modelos matemáticos del proceso de entrenamiento tiene algunos años, pero lo nuevo aquí es que la mayoría del trabajo previo se enfocaba en analizar lo que sucedió después de entrenar varios modelos, para tomar mejores decisiones en futuros entrenamientos”.

Extrapolación y predicciones efectivas

Desarrollar LLMs es una tarea costosa que implica decisiones sobre parámetros, selección de datos y técnicas de entrenamiento. Las leyes de escalado permiten prever el comportamiento del modelo, relacionando la pérdida de un modelo grande con el rendimiento de modelos más pequeños y menos costosos.

Según Leshem Choshen, estas leyes no solo ayudan a tomar mejores decisiones de pre-entrenamiento, sino que también democratizan el campo, permitiendo que investigadores con menos recursos comprendan y construyan leyes de escalado efectivas.

El funcionamiento de las leyes de escalado es relativamente simple e incorpora elementos de los modelos pequeños que capturan el número de parámetros y su efecto de escalado, así como el número de tokens de entrenamiento. Juntas, estas métricas ayudan a los investigadores a estimar la pérdida de rendimiento de un modelo grande: cuanto menor sea la pérdida, más probables serán los buenos resultados del modelo objetivo.